在GTC 2022上,英偉達發布了新一代基於Hopper架構的H100,用於下一代加速計算平台。正如英偉達所言,這是專門為超級計算機設計的GPU,專注於AI性能,通過架構更新和工藝提升,使其性能和效率提高到新的水平。

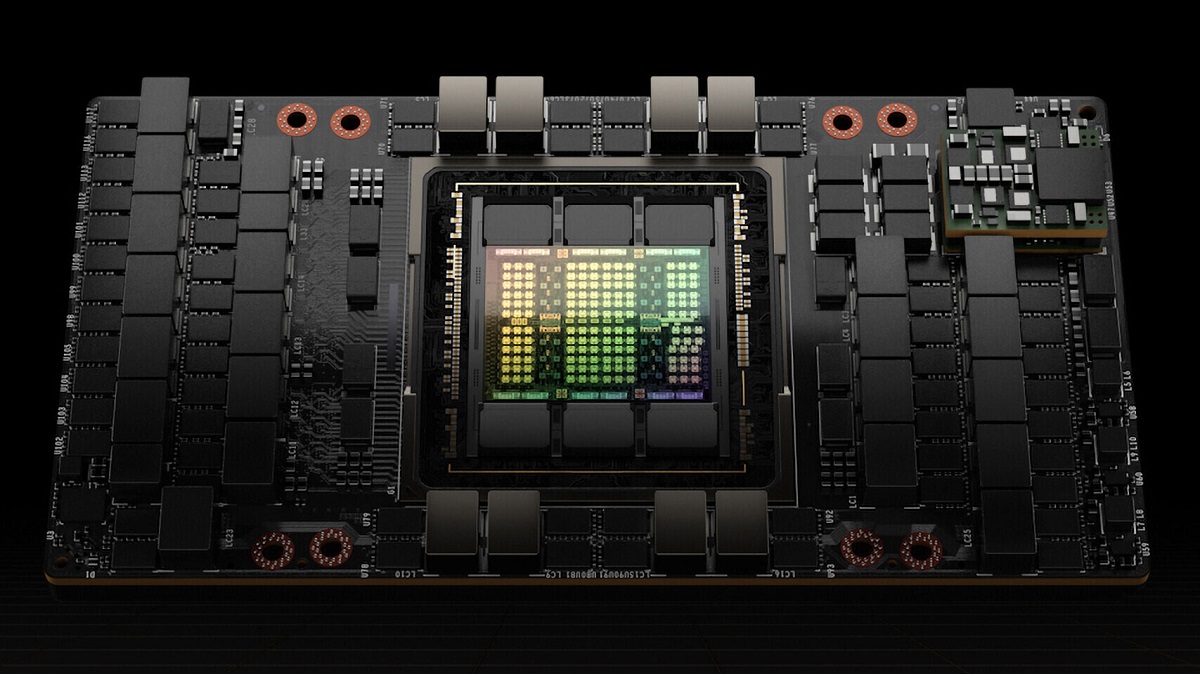

NVIDIA H100擁有800億個電晶體,相比上一代的A100,有著六倍的性能提升以及兩倍的MMA改進。該款GPU為CoWoS 2.5D晶圓級封裝,單晶片設計,採用了台積電(TSMC)的4nm工藝製造,不過是為英偉達量身定製的版本,與一般的N4工藝有所差別。

英偉達沒有公布H100的核心數量和頻率。據了解,完整的GH100晶片配置了8組GPC、72組TPC、144組SM、共18432個FP32 CUDA核心。其採用了第四代Tensor Core,共576個,並配有60MB的L2緩存。有不過實際產品中沒有全部打開,其中SXM5版本中啟用了128組SM,共15872個FP32 CUDA核心,528個Tensor Core以及50MB的L2緩存,而PCIe 5.0版本雖然也啟用了128組SM,但FP32 CUDA核心只有14952個。此外,前者的TDP達到了700W,後者則為350W。

英偉達表示H100的FP64/FP32運算性能為60 TFlops,FP16運算性能為2000 TFlops,TF32運算性能為1000 TFlops,均是A100的三倍。此外英偉達在Hopper架構上改進了對FP8運算的支持,使其運算性能達到了4000 TFlops,是A100六倍。由於缺乏原生FP8,不得不依賴於FP16,英偉達通過新的轉換器引擎,將根據工作負載在FP8和FP16之間自動切換。

據英偉達介紹,H100支持英偉達第四代NVLink接口,可提供高達900 GB/s的帶寬。同時H100還支持不使用NVLink接口的系統,以PCIe 5.0代替,帶寬為128 GB/s。英偉達表示,H100是第一款支持PCIe 5.0標準的GPU,也是第一款採用HBM3的GPU,最多支持六顆HBM3,帶寬為3TB/s,是A100採用HBM2E的1.5倍,默認顯存容量為80GB。

英偉達還添加了旨在加速動態編程的新DPX指令,以幫助更廣泛的算法,包括路線優化和基因組學。英偉達表示這些算法的性能比其上一代GPU快了七倍,比基於CPU的算法快了四十倍。Hopper架構還對安全性做了改進,多實例GPU(MIG)現在允許在單個H100 GPU上運行七個安全租戶。

與A100一樣,英偉達會將新款的H100添加到DGX H100機架式伺服器。每個DGX H100系統包含8塊H100,共640GB的HBM3顯存,可提供32 PFlops的AI計算性能,以及480 TFlops的FP64運算性能。系統中的每個GPU都通過第四代NVLink連接,帶寬是上一代的1.5倍,加上全新的VNLink Swtich互連系統,可連接32個DGX H100節點,以構建下一代NVIDIA DGX SuperPOD超級計算機。

由於H100分別有SXM和PCIe兩種外形,以支持不同的伺服器設計要求。為了更好地適應不同的系統,英偉達還提供了H100 CNX融合加速器,將H100與NVIDIA ConnectX-7 400Gb/s InfiniBand和乙太網SmartNIC配對,為I/O密集型應用提供突破性的性能。Hopper架構GPU還可以與具有NVLink-C2C互連的Grace CPU搭配使用,成為Grace Hopper超級晶片,為大規模HPC和AI應用提供服務。

NVIDIA H100可廣泛部署在各種類型的數據中心里,將向全球范圍內的雲服務供應商和計算機製造商提供,預計今年第三季度開始供貨。

來源:超能網